A solução MLOps da New Relic fornece uma biblioteca Python que facilita o monitor de seus modelos de aprendizado de máquina. New Relic Bring Your Own (BYO) Machine Learning Model Monitoring é uma oferta do conjunto de produtos New Relic que permite ao usuário monitor o desempenho de seus próprios modelos de aprendizado de máquina, independentemente da plataforma ou framework que estiver usando. Isso pode ajudar o usuário a identificar problemas com seus modelos e tomar medidas corretivas antes que esses problemas afetem a precisão ou o desempenho do aplicativo.

Num espaço digital cada vez mais complexo, as equipas de dados dependem fortemente de motores de previsão para tomar decisões. O monitoramento do modelo de aprendizado de máquina da New Relic permite que sua equipe dê um passo atrás e observe o cenário completo. Nosso monitoramento de desempenho do modelo permite que sua equipe examine seus modelos de ML para identificar problemas de forma eficiente e tomar decisões, aproveitando o recurso principal do NR, como definir alerta em qualquer métrica e ser notificado assim que seu desempenho de ML mudar.

Fácil de integrar

O pacote ml-desempenho-monitoramento python, baseado em newrelic-telemetry-sdk-python, permite enviar os valores de recurso e predição do seu modelo, bem como métrica personalizada, bastando adicionar algumas linhas ao seu código.

Use o pacote python para enviar os seguintes tipos de dados para o New Relic:

Inference data:

Transmita os valores de recurso e previsão do seu modelo. Os dados de inferência são transmitidos como um evento personalizado denominado InferenceData.

Data metrics:

Em vez de enviar todos os seus dados brutos de inferência, selecione a opção de estatísticas agregadas sobre o recurso e as previsões (por exemplo, mínimo, máximo, média ou percentil). Serão enviados automaticamente como métrica.

Custom metrics:

Calcule sua própria métrica, monitor o desempenho do seu modelo ou os dados do modelo e transmita-os para o New Relic usando a função record_metrics. Serão enviados como métrica.

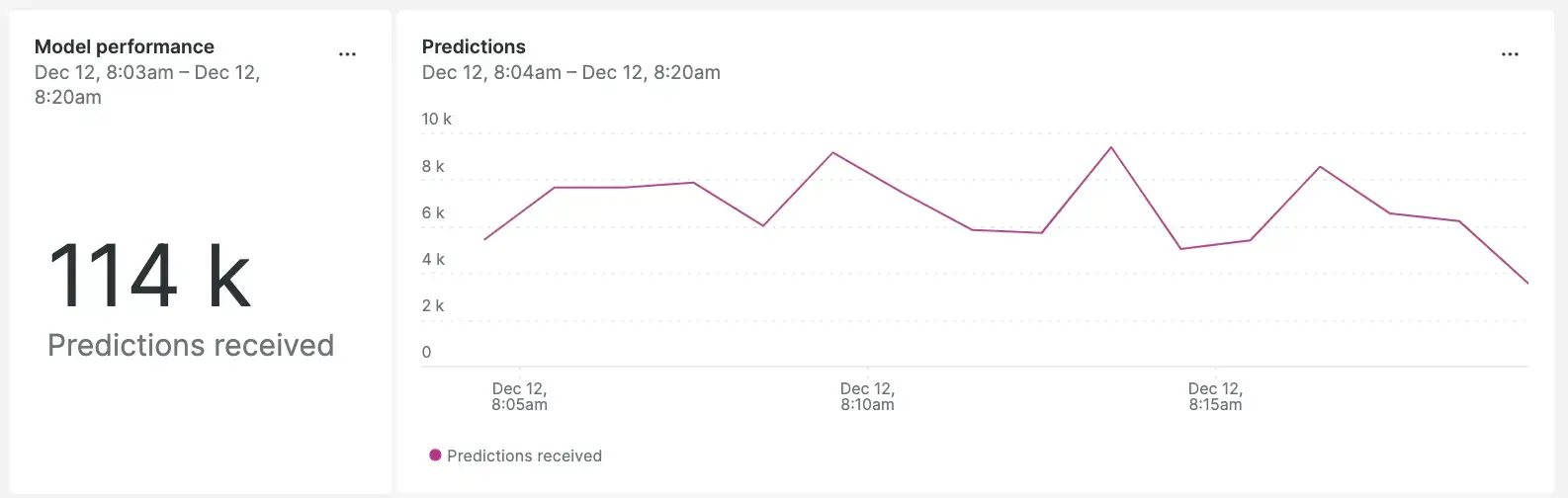

Ver previsões do modelo

Ao monitorar o desempenho dos seus modelos de machine learning, você pode identificar quaisquer problemas que possam estar impactando sua precisão ou desempenho. Você verá informações vitais em seu dashboard , como previsões totais do modelo e distribuição ao longo do tempo. Além disso, você pode definir para rastrear quaisquer alterações nas previsões totais ou escolhas altas/baixas.

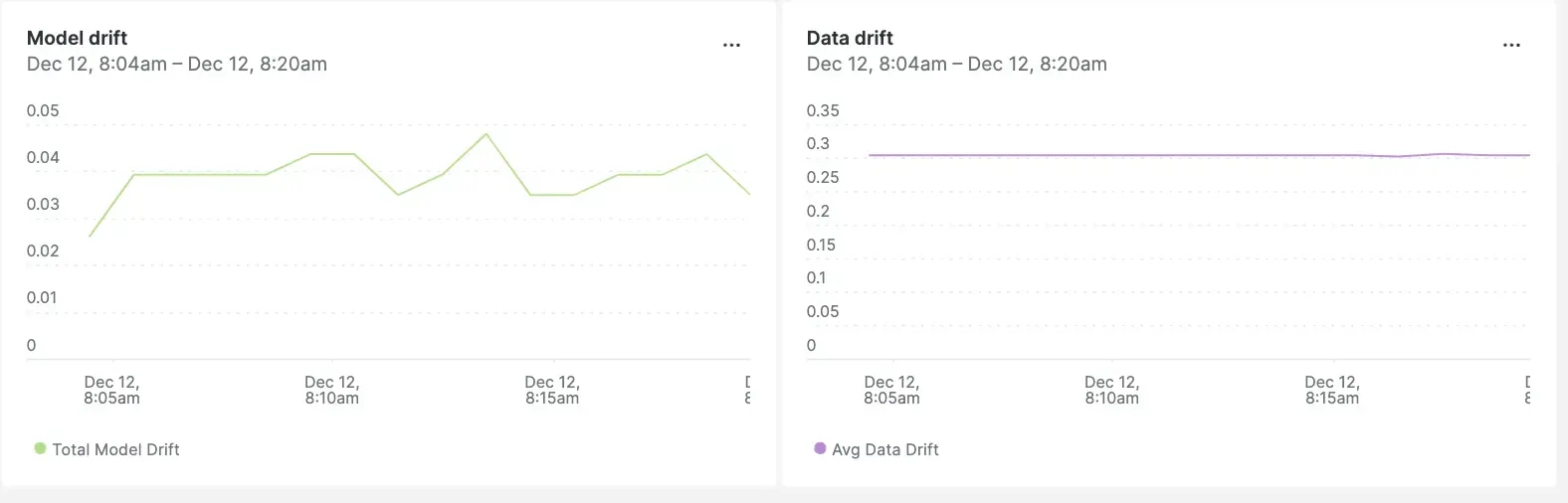

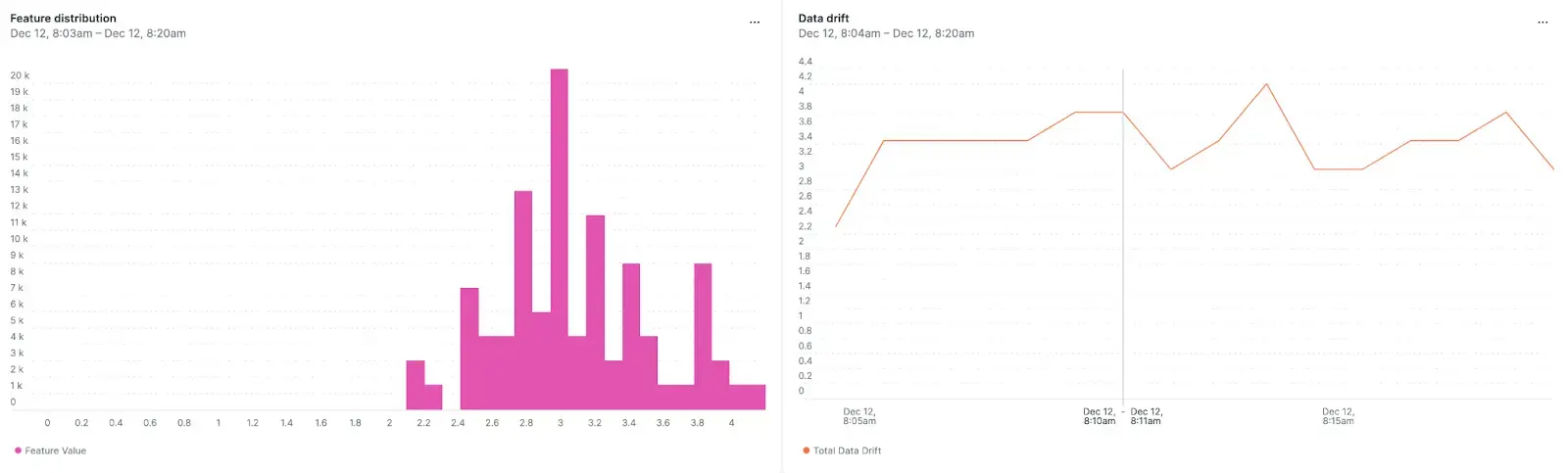

Detectar modelo e imprecisão de dados

Com o monitoramento em tempo real, você pode identificar rapidamente problemas em seus modelos de aprendizado de máquina, detectando modelo e imprecisão de dados. Modelo e imprecisão de dados são mudanças no seu ambiente do mundo real que podem afetar o poder preditivo do seu modelo. Ao obter dados em tempo real sobre seu modelo e imprecisão de dados, você pode tomar ações corretivas rapidamente antes que esses problemas afetem o desempenho do seu aplicativo.

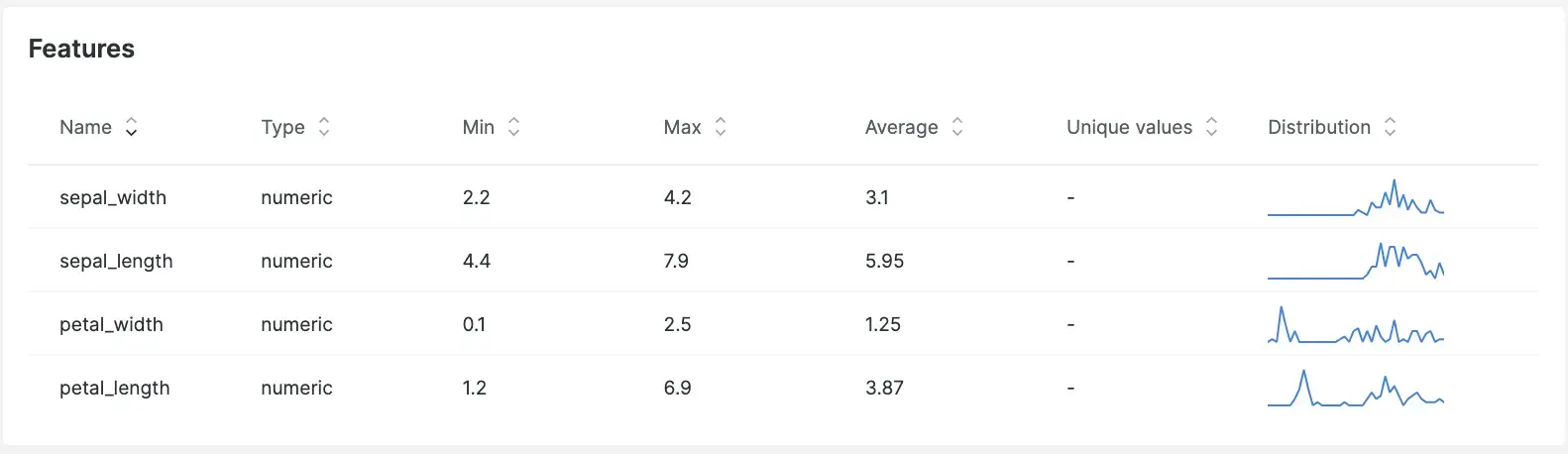

Mergulhe mais fundo no recurso Modelo

Obtenha insights e dados estatísticos sobre seu recurso e receba alertas sobre qualquer Desvio de comportamento padrão e esperado.

Como começar a monitorar o desempenho do seu modelo de ML

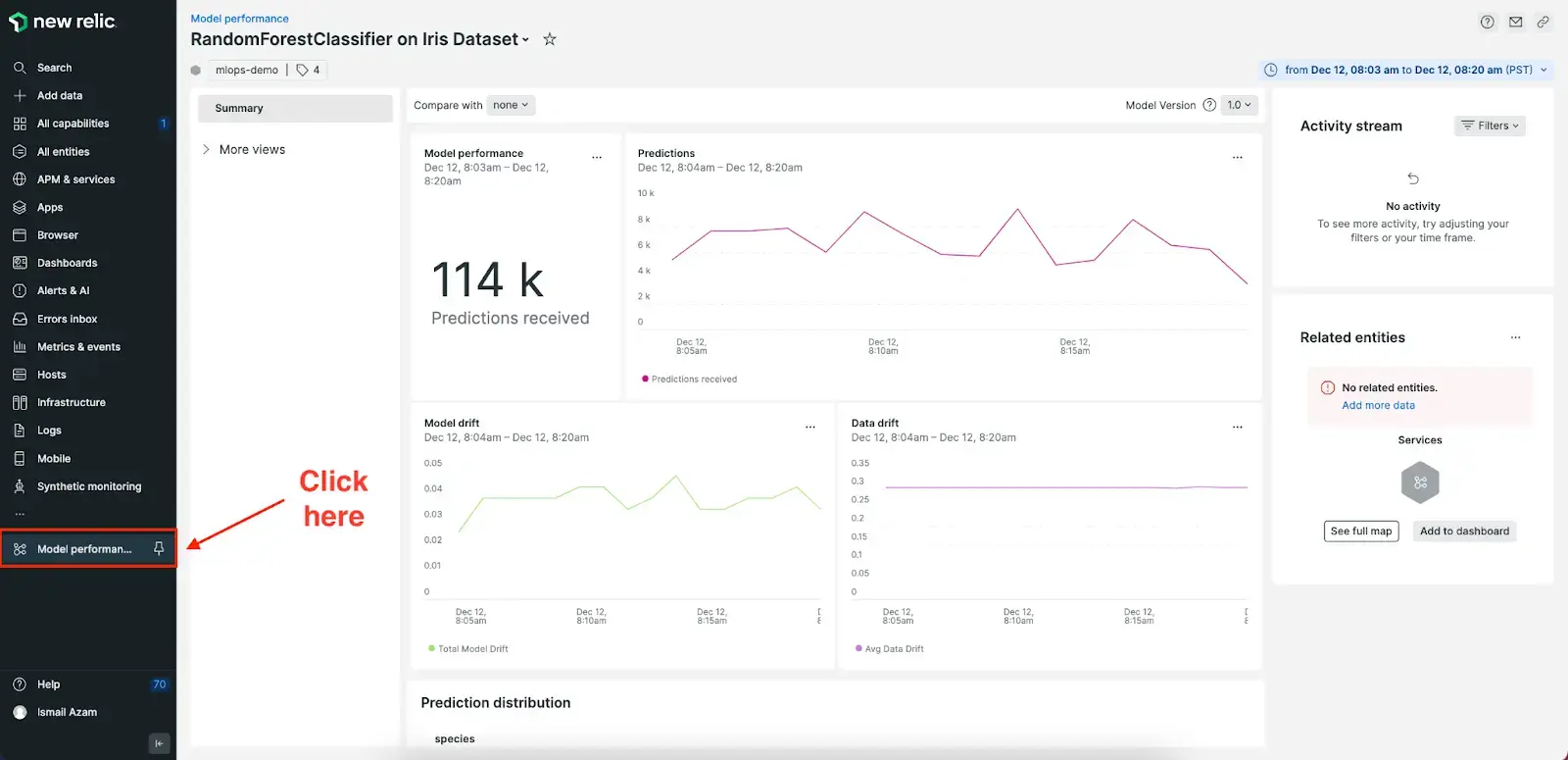

Primeiro, use a documentação de primeiros passos para iniciar o streaming dos dados do seu modelo. Em seguida, clique em Model Performance na página All Capabilities na interface do New Relic (não se esqueça de fixá-lo) e você verá a visualização do desempenho do seu modelo com base nos dados que seu modelo está enviando.